Ansiktsgjenkjenning som kan "glemme" deg

CSEM utvikler KI-modeller som «glemmer ansiktet ditt» – Beskytter personvernet i overvåkingens tidsalder

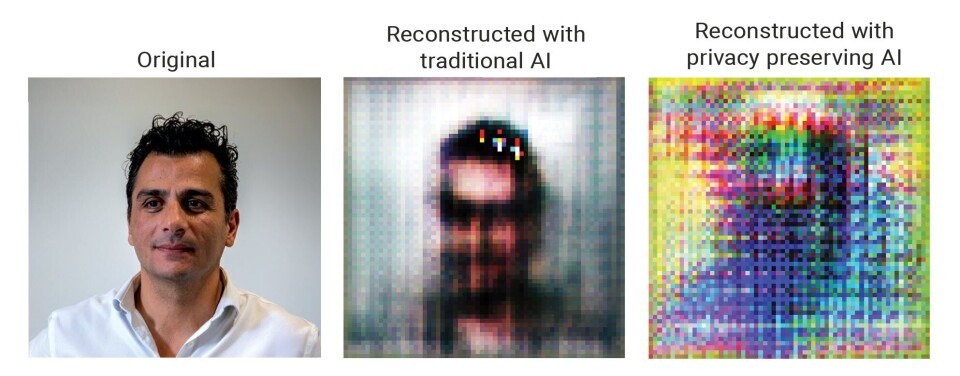

Ansiktsgjenkjenning og KI-overvåking sprer seg raskt, fra flyplasser til sykehus, smarte byer og personlige enheter. Selv om disse verktøyene lover økt sikkerhet og effektivitet, reiser de også store bekymringer rundt personvern, samtykke og algoritmisk skjevhet. Nå har forskere ved det sveitsiske forskningsinstituttet CSEM utviklet en banebrytende løsning: En KI-treningsmetode som utfører komplekse overvåkingsoppgaver samtidig som den ugjenkallelig sletter personlige trekk som ansikter, kjønn eller alder fra minnet.

Endrer bildespekteret

CSEM har utviklet en kraftig ny AI-treningsmetode som muliggjør befolkningsovervåking (for eksempel på offentlige steder eller sykehus) samtidig som den beskytter individets personvern og forhindrer skjevhet. Metoden bruker en «kontradisjonell treningsstrategi», som introduserer et såkalt «vaktbikkje»-nettverk i løpet av AI-ens treningsfase. Denne interne utfordreren oppdager når systemet prøver å beholde informasjon det ikke burde (for eksempel noens alder) og tvinger det til å glemme. Resultatet: AI som fortsatt kan overvåke folkestrømmer, oppdage helseavvik eller støtte tilgangskontroll – uten noen gang å fange opp hvem du er.

– Med denne teknologien beviser vi at etisk, personvern-sentrisk KI ikke bare er mulig – den er praktisk, sier Nadim Maamari, gruppeleder hos CSEM.

Ytelse og beskyttelse – ingen kompromisser

Nyskapningen, utviklet av CSEMs gruppe «Edge AI and Vision Systems», ble testet med både medisinske data og ansiktsbilder. Den viste at modeller trent med den personvernbevarende metoden presterte bedre enn tradisjonelle AI-systemer, og forbedret oppgavens nøyaktighet med opptil 6,7 %. Enda viktigere, den viste seg å være motstandsdyktig mot moderne personvernangrep, inkludert forsøk på å reversere ansikter fra modellparametere. Disse resultatene ble nylig presentert på den 22. internasjonale konferansen om distribuert databehandling og kunstig intelligens (DCAI) i Frankrike.

Kort sagt: Ingen sensitive data trenger å lagres, overføres eller engang sees av systemet. Denne tilnærmingen muliggjør sikker AI-distribusjon i sektorer som helsevesen, offentlig sikkerhet, urban mobilitet og forbrukerelektronikk.

Global relevans

Ansiktsgjenkjenningsteknologi (FRT) utvikler seg raskt. Systemer som Metas Deep Face matcher nå menneskelig nøyaktighet. I 2024 skannet britisk politi over 4,7 millioner ansikter ved hjelp av ansiktsgjenkjenning i sanntid, noe som bidro til hundrevis av arrestasjoner. En amerikansk meningsmåling fra 2020 fant at 66 % støtter FRT i politiet.

Likevel er det fremdeles store bekymringsmomenter. Nøyaktigheten varierer fortsatt dramatisk på tvers av demografiske grupper, med feilrater så høye som 34,7 % for mørkere kvinner mot 0,8 % for lyshudede menn. Tilliten til offentligheten er splittet, spesielt når kommersielle eller statlige aktører er involvert.

Regjeringer over hele verden reagerer. Kina har innført regler for åpenhet og samtykke. EU ferdigstiller sin KI-lov. I mellomtiden tar Sveits en sektortilnærming og integrerer KI-tilsyn i eksisterende juridiske strukturer.

Sveits: Reguleringen strammes inn, innovasjon oppstår

Sveits' reviderte føderale databeskyttelseslov (FADP), som trådte i kraft september 2023, klassifiserer biometriske data som svært sensitive. Som bekreftet av den føderale databeskyttelses- og informasjonskommissæren, er storskala ansiktsgjenkjenning i sanntid i offentlige rom i praksis forbudt uten spesifikk juridisk begrunnelse.

I en underskriftskampanje fra 2021 ba sveitsiske borgere om et nasjonalt forbud mot overvåkingsbasert ansiktsgjenkjenning, og 80 % av parlamentskandidatene støttet strengere kontroller i 2023. Kantonale initiativer går også fremover: Neuchâtel nedfelte «digital integritet» i sin grunnlov, St. Gallen tester ut e-signaturer, og Lausanne forfølger reformer av digital styring.

Designet for distribusjon i den virkelige verden.

CSEMs metode hevdes å støtte dette regelverket ved å sikre at KI aldri lagrer eller behandler sensitive personopplysninger (som identitet, kjønn eller etnisitet), noe som reduserer risikoen for misbruk, profilering og personvernangrep. Teknologien beskrives som kompakt, energieffektiv og ideell for bruk i innvevde systemer. Den sikrer at KI-systemer bare lærer det de trenger for oppgaven sin. Ingen private data trenger å lagres eller deles. Systemet «avlærer» aktivt hvem du er og fokuserer bare på det som er viktig, noe som skal gjøre det egnet for ansvarlige applikasjoner innen helse, sikkerhet og offentlige tjenester.

Teknologien er ifølge CSEM testet, operativ og klar for utrulling i dag.